Ein interessanter Artikel über Index-Bloat und wie man es behebt

Was ist Index-Bloat?

Index-Bloat bezieht sich auf Websites mit einer hohen Seitenanzahl, die mit Seiten von geringem Wert 'aufgebläht' sind. Diese Seiten werden dann von den Suchmaschinen indexiert, was sich negativ auf die Leistung Ihrer Website auswirkt.

Warum ist Index-Bloat schlecht für SEO?

Das Hauptproblem ist, dass der Index-Bloat bedeutet, dass die Seiten von geringem Wert die Seiten von hohem Wert überwiegen. Dies führt dazu, dass Suchmaschinen Ihre Website als geringwertig betrachten. Selbst wenn Sie sich bei Ihren wertvollen Seiten Mühe geben, werden diese durch die Seiten von geringem Wert überlagert.

Ihr primäres Ziel bei SEO ist es, dass der Crawler einer Suchmaschine in der Lage ist:

- Den Inhalt zu finden, den Sie möchten, dass er gefunden wird.

- Dieser gut in den Suchergebnissen zu ranken.

- Inhalte zu ignorieren, die Sie nicht indexiert haben möchten.

Wenn eine Website eine hohe Seitenanzahl hat, aber viele dieser Seiten von geringer Qualität sind, verschwendet dies Ihr wertvolles Crawl-Budget. Dies kann dann das Gesamtranking Ihrer Website in den Suchmaschinen verschlechtern. Aus diesem Grund ist es wichtig, dies regelmäßig im Auge zu behalten.

Was sind die Ursachen für Index-Bloat?

E-Commerce-Seiten sind häufig von Index-Bloat betroffen, da sie typischerweise viele Produktseiten haben. Selbst nachdem Produkte nicht mehr verfügbar sind, kann die URL und die Seite weiterhin indexiert sein. Produktsuchen und Filterfunktionen können ebenfalls Hunderte oder Tausende von 'aufgeblähten' Seiten verursachen. Es gibt auch viele andere Ursachen für Index-Bloat, wie zum Beispiel:

- Interne doppelte Links und Paginierung.

- Tracking-URLs, die eine Abfragezeichenfolge am Ende enthalten.

- Automatisch generierte Benutzerprofile.

- Website-Entwicklung, Migration und Wiederaufbau lassen oft nutzlose Testseiten zurück.

- Blog-Websites generieren häufig Archivseiten wie monatliche Archive, Blog-Tags, Kategorietags usw. Im Laufe der Zeit summieren sich diese zu erheblichem Bloat-Inhalt.

- Eine schlecht geordnete XML-Sitemap und interne Verlinkung. Wenn eine Sitemap nicht richtig durchdacht ist, kann dies zu verschwendetem Crawl-Budget führen.

- Allgemeine Seiten mit geringem Wert, wie 'Danke'- oder Testimonials-Seiten. Diese gelten als qualitativ minderwertiger Inhalt und sollten nicht von Suchmaschinen-Crawlern indexiert werden.

Im Wesentlichen ist jede Seite, die von einer Suchmaschine gelistet wird und dem Benutzer keinen Wert bietet, Index-Bloat. Einige sind unvermeidlich, aber das Ziel sollte sein, sie so weit wie möglich zu minimieren.

Wie man Index-Bloat auf Ihrer Website behebt

Sie haben wirklich zwei Optionen:

- Sie löschen die unerwünschten Seiten.

- Sie sagen den Suchmaschinen, dass sie diese nicht indexieren sollen.

Soweit es einfach klingt, kann es einige Zeit in Anspruch nehmen, dies zu tun. Es kann auch einige Zeit dauern, bis positive Ergebnisse aus Ihrer Arbeit sichtbar werden. Seien Sie jedoch versichert, dass sich dies über die Zeit auszahlen wird. Um die Seiten zu ermitteln, die entfernt werden müssen, müssen Sie die Indexrate Ihrer Website analysieren (wobei Sie die wichtigen Seiten auflisten, die indexiert werden müssen). Dann müssen Sie dies mit den Seiten abgleichen, die Google indexiert hat. Der Überschuss ist der Index-Bloat, den Sie loswerden möchten.

Sie können auch den Zugriff auf Inhalte einschränken und die Indexierung durch Web-Crawler verhindern

Obwohl Sie Web-Crawler nicht daran hindern können, auf eine Seite zuzugreifen, können Sie ihnen anweisen, diese nicht zu indexieren. Die meisten Suchmaschinen werden dieser Anweisung folgen, aber andere möglicherweise nicht, sodass dies keine narrensichere Methode ist.

Wenn Sie Inhalte haben, die wirklich vertraulich sind, benötigen Sie fortgeschrittenere Sicherheitsfunktionen, um die Web-Crawler zu blockieren. Eine davon ist die .htaccess-Datei, die steuern kann, wer was in einzelnen Ordnern sieht. Dies ist jedoch ein komplexer, technischer Prozess, der nicht von Anfängern durchgeführt werden sollte!

4 einfache Möglichkeiten, um Index-Bloat zu beheben

`-Bereich. Dies kann wie folgt erfolgen:

- Löschen Sie doppelte Seiten, unerwünschte Seiten, alte Testseiten usw.

- Entfernen Sie Seiten von geringem Wert aus Ihrer XML-Sitemap und kennzeichnen Sie sie mit einem noindex-Meta-Tag im HTML `

<head> <meta name="robots" content="noindex"> </head> - Setzen Sie eine Disallow-Direktive in Ihrer robots.txt-Datei, um anzugeben, welche Ordner oder einzelnen Seiten nicht gecrawlt werden sollen. Dieser Inhalt wird dann nicht gecrawlt oder von Suchmaschinen indexiert.

User-agent: googlebot Disallow: /testimonials/ Disallow: /checkout/ Disallow: /content-page1.htm/ - Setzen Sie eine noindex-Direktive in Ihrer robots.txt-Datei. Die Seiten werden gecrawlt, aber nicht von Suchmaschinen indexiert.

Noindex: /content-page1.htm/

Do's und Don'ts beim Beheben von Index-Bloat

- Erlauben Sie nicht, dass interne Suchergebnisseiten (wenn ein Benutzer die Suchleiste auf Ihrer Website verwendet) von Suchmaschinen gecrawlt werden. Andernfalls können Suchende auf einen Link in den Suchergebnissen klicken, aber auf eine andere Suchergebnisseite auf Ihrer Website geleitet werden. Dies würde eine schlechte Benutzererfahrung bieten.

- Wenn Proxy-Dienste URLs für Ihre Website generieren, erlauben Sie nicht, dass diese gecrawlt werden.

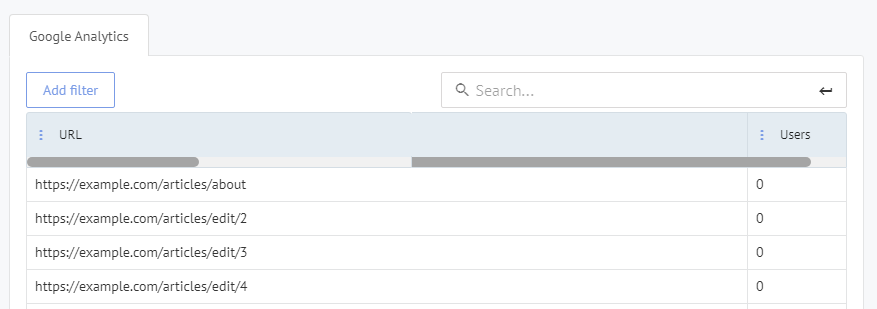

- Führen Sie ein gründliches SEO-Audit durch, entweder von einem SEO-Spezialisten oder mit einem Online-Tool, wie uns hier bei Labrika. Unser Benutzerverhalten-Bericht ermöglicht es Ihnen, Seiten zu sehen, die keinen Traffic haben und daher wahrscheinlich Ihre Website 'aufblähen'.

Zusammenfassung: Finden und Beheben von Index-Bloat

Das Hauptziel jeder Suchmaschine ist es, die besten Ergebnisse für ihre Benutzer zu liefern. Um dies zu erreichen, setzen sie erhebliche Ressourcen ein, um Seiten (oder ganze Websites) zu identifizieren und auszuschließen, die ihre Kriterien nicht erfüllen.

Dies ist auch ein Prozess, der weiterhin verbessert und verfeinert wird. Das bedeutet, dass wir als SEO-Profis und Webmaster unser Bestes tun müssen, um diesen Problemen zuvorzukommen.

Diese Art von technischem SEO-Problem sollte ein wichtiger Bestandteil jeder Qualitätsüberprüfung einer Website werden. Stellen Sie sicher, dass Crawler nur das Beste Ihres Inhalts sehen!

Die Durchführung der oben beschriebenen Fixes ist ein wichtiger Schritt zur Optimierung Ihrer SEO-Bemühungen.